캐시 메모리 계층 구조 및 캐싱 알고리즘: 성능 최적화의 핵심

캐시 메모리는 컴퓨터 시스템에서 성능을 극대화하기 위한 중요한 역할을 합니다. 이는 데이터를 처리하는 속도를 비약적으로 향상시키며, 중앙처리장치(CPU)와 주기억장치(RAM) 간의 데이터 이동을 최적화하는 데 필수적인 요소입니다. 이 글에서는 캐시 메모리 계층 구조와 각 계층에서 사용되는 캐싱 알고리즘에 대해 상세히 설명하고, 이를 통해 시스템 성능이 어떻게 향상될 수 있는지 이해해보겠습니다. 또한 최신 컴퓨터 시스템에서 캐시 메모리 관리 방식이 어떻게 적용되는지에 대해서도 다룰 것입니다.

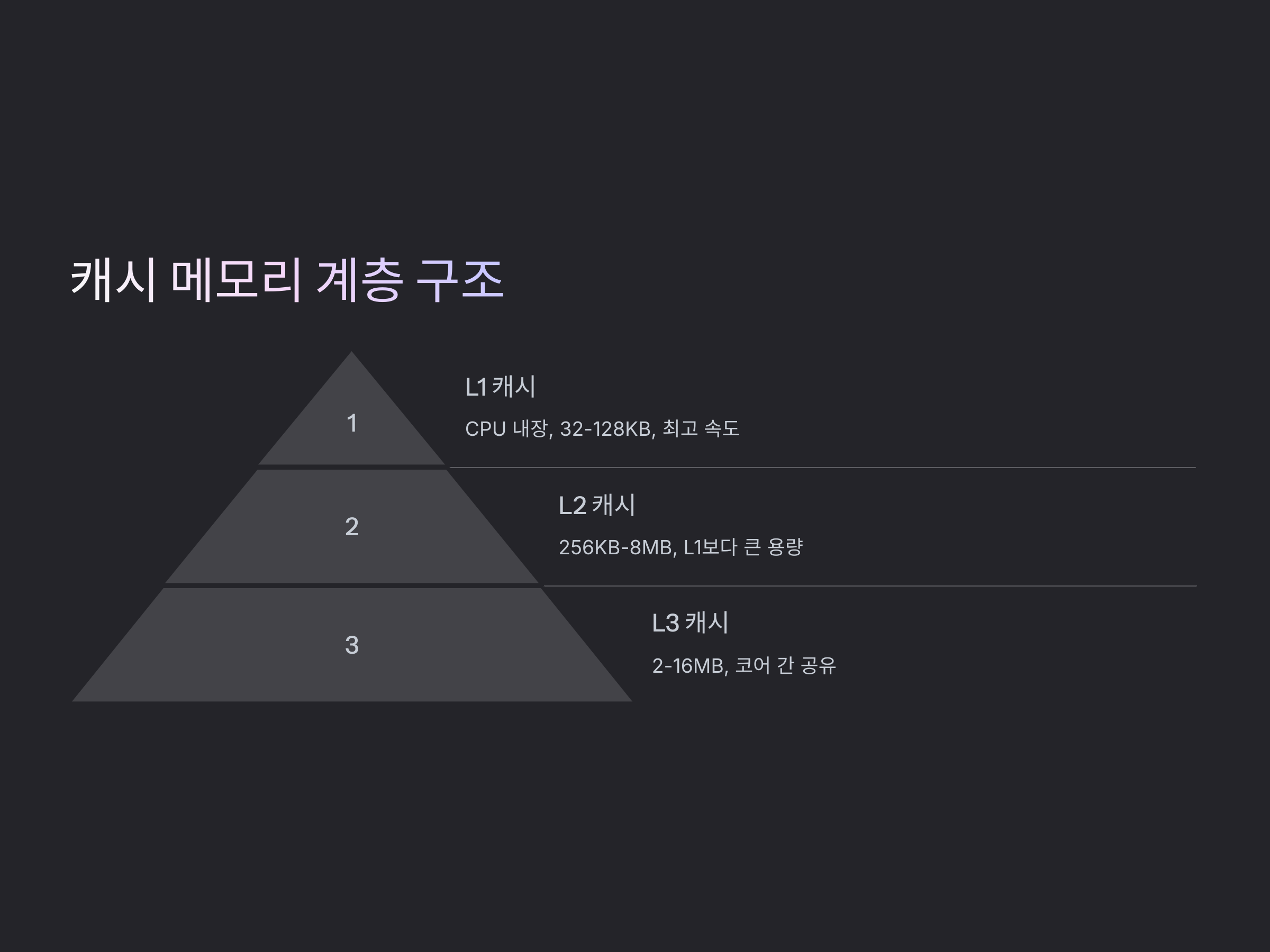

캐시 메모리 계층 구조

캐시 메모리는 여러 계층으로 나누어져 있으며, 각 계층은 성능과 용량에 따라 다르게 설계됩니다. 캐시 메모리의 주요 계층은 일반적으로 L1, L2, L3 캐시로 구분되며, 각 계층은 CPU와의 거리가 가까울수록 빠르지만 용량이 작고, 멀어질수록 용량은 커지지만 속도는 느려집니다.

L1 캐시

L1 캐시는 CPU와 가장 가까운 위치에 있는 캐시입니다. 이는 CPU 내부에 내장되어 있으며, 매우 빠른 속도를 제공합니다. L1 캐시는 주로 데이터와 명령어를 저장하며, 그 크기는 상대적으로 작습니다. 일반적으로 32KB에서 128KB 정도의 용량을 가지며, 빠른 응답속도를 위해 설계되었습니다.

L2 캐시

L2 캐시는 L1 캐시보다 조금 더 멀리 위치하며, 크기도 더 큽니다. 일반적으로 256KB에서 8MB 정도의 용량을 가집니다. L2 캐시는 CPU 코어와 근접한 위치에 배치되며, L1 캐시에서 데이터를 찾지 못할 경우에 대비하여 더 많은 데이터를 저장하고 있습니다. L2 캐시의 속도는 L1 캐시보다는 느리지만, 여전히 RAM보다 훨씬 빠릅니다.

L3 캐시

L3 캐시는 여러 CPU 코어가 공유하는 캐시입니다. 이 캐시는 L1 및 L2 캐시보다 크기가 크며, 보통 2MB에서 16MB 정도의 용량을 가집니다. L3 캐시는 CPU 코어들 간에 데이터를 공유할 수 있도록 설계되었으며, 모든 코어가 L3 캐시를 통해 데이터를 교환하게 됩니다. 이 캐시는 CPU와 메인 메모리(RAM) 간의 데이터 전송 효율을 높이는 중요한 역할을 합니다.

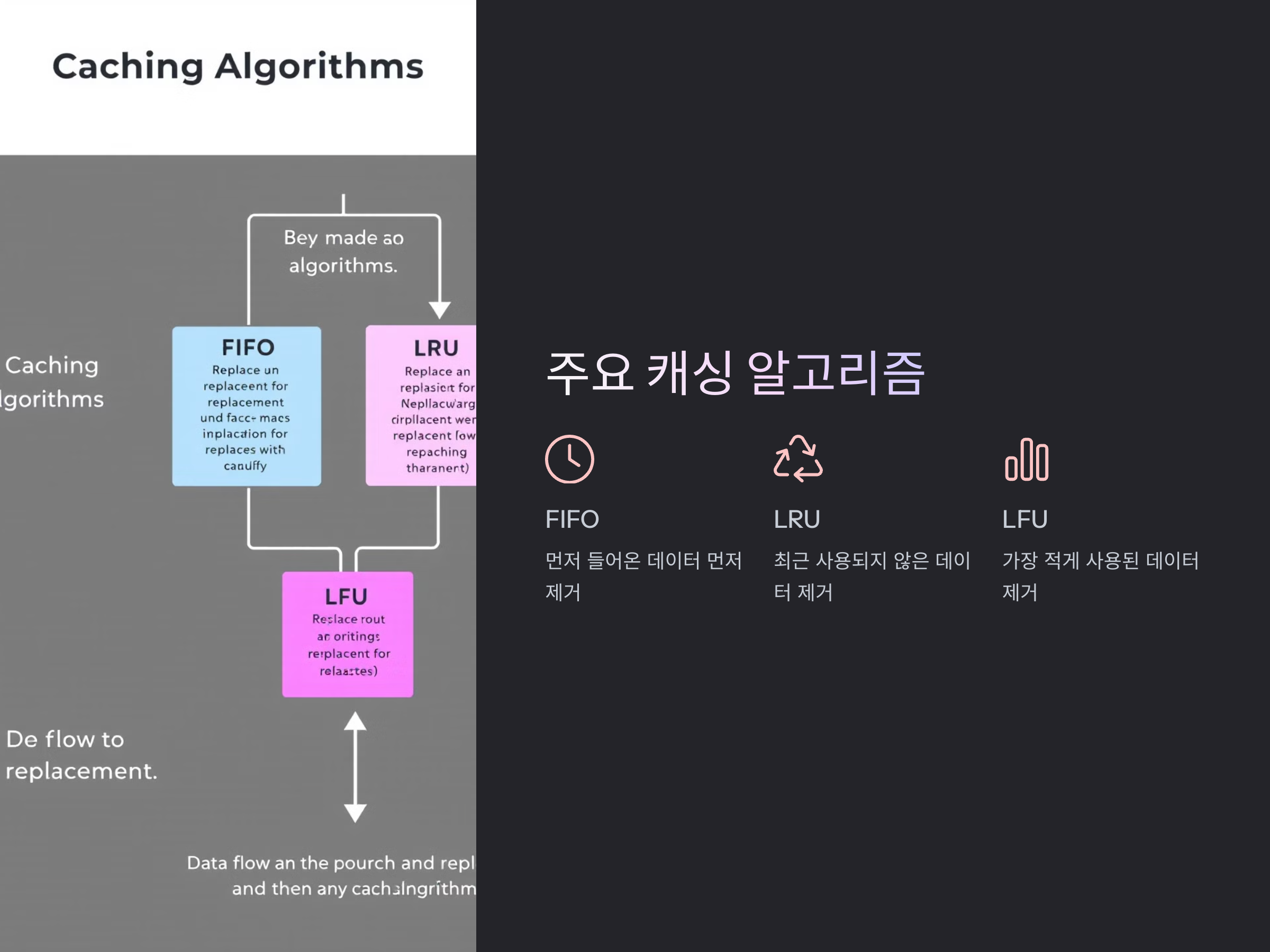

캐싱 알고리즘의 개요

캐싱 알고리즘은 데이터를 캐시에 저장하거나 캐시에서 제거하는 방법을 정의합니다. 효과적인 캐싱 알고리즘은 시스템 성능을 향상시키며, 메모리의 유효 활용도를 최적화합니다. 주요 캐싱 알고리즘에는 FIFO, LRU, LFU 등이 있습니다.

FIFO(First In, First Out)

FIFO 알고리즘은 가장 먼저 캐시에 들어온 데이터를 가장 먼저 제거하는 방식입니다. 이는 구현이 간단하고 직관적이지만, 자주 사용되는 데이터가 오래된 데이터보다 먼저 제거될 위험이 있기 때문에 성능이 최적화되지 않는 경우가 많습니다. 그러나 일부 간단한 시스템에서는 여전히 사용됩니다.

LRU(Least Recently Used)

LRU 알고리즘은 가장 오래된(최근에 사용되지 않은) 데이터를 제거하는 방식입니다. 이는 캐시에서 자주 사용되는 데이터를 우선적으로 보존할 수 있도록 도와줍니다. LRU는 FIFO보다 더 효율적이며, 최근에 사용된 데이터를 더 많이 유지함으로써 시스템의 성능을 최적화합니다. 대부분의 시스템에서 사용되는 캐싱 알고리즘 중 하나입니다.

LFU(Least Frequently Used)

LFU 알고리즘은 가장 적게 사용된 데이터를 제거하는 방식입니다. 이 알고리즘은 데이터를 사용하는 빈도를 기준으로 데이터를 관리하며, 자주 사용되는 데이터가 캐시에 더 오래 남게 됩니다. LFU는 데이터의 접근 패턴이 일정하거나 예측 가능한 경우에 유용합니다.

최신 캐시 메모리 관리 기법

최근의 시스템에서는 전통적인 캐싱 알고리즘 외에도 다양한 기술이 적용되고 있습니다. 예를 들어, 하드웨어 기반 캐싱 기법과 소프트웨어 기반 캐싱 기법의 결합을 통해 성능을 더욱 최적화하는 방법들이 사용되고 있습니다. 또한, 고급 프로세서에서는 비동기식 데이터 전송 기술과 캐시 일관성 유지 기법들이 도입되어, 멀티코어 시스템에서도 효율적인 캐시 관리를 실현하고 있습니다.

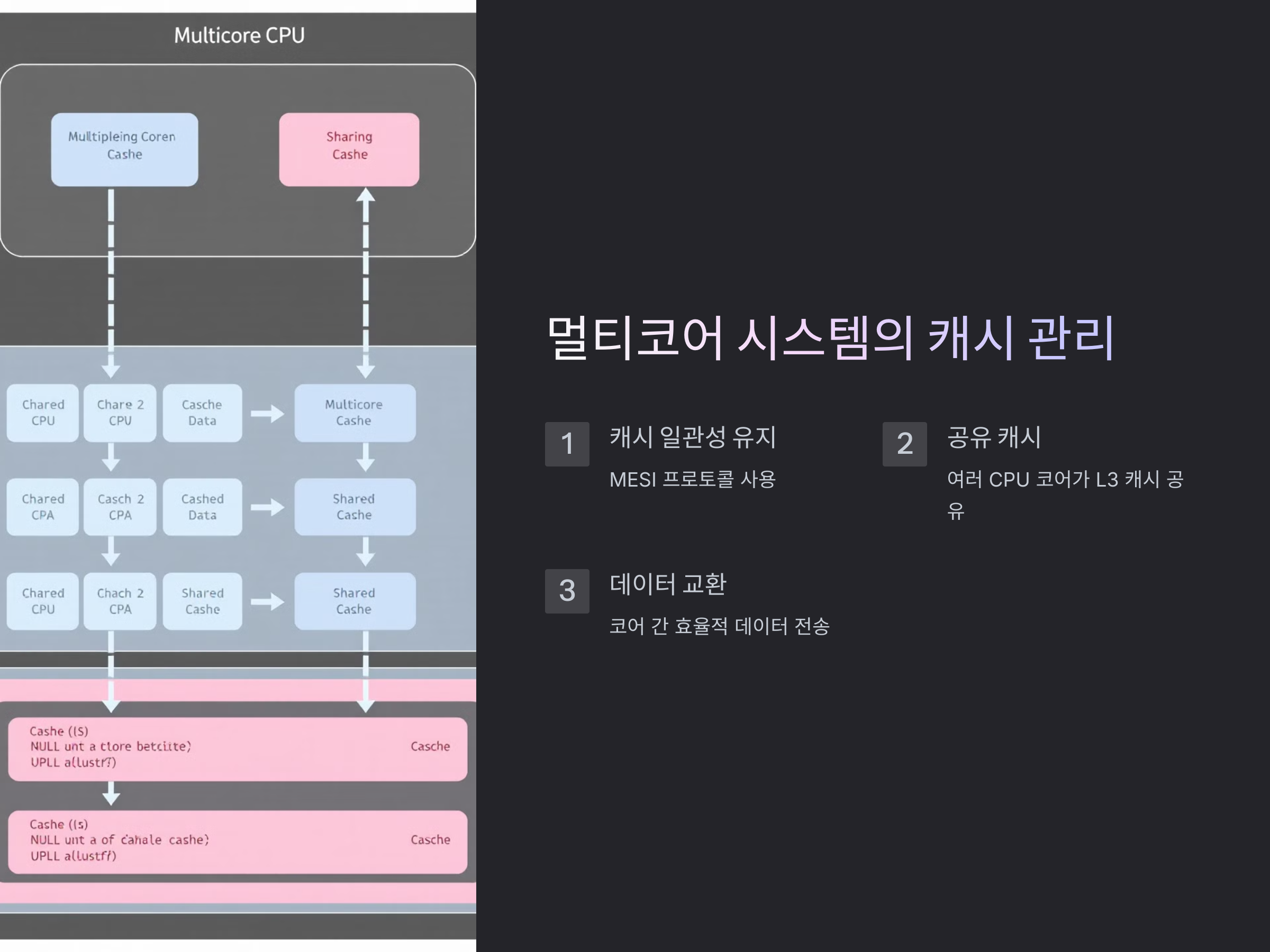

멀티코어 시스템에서의 캐시 관리

멀티코어 시스템에서는 여러 CPU 코어가 동일한 캐시 메모리를 공유하는 경우가 많습니다. 이러한 환경에서 캐시 일관성 유지가 중요한데, 이를 위해 MESI(Modified, Exclusive, Shared, Invalid) 프로토콜이 사용됩니다. 이 프로토콜은 각 캐시가 동일한 데이터에 대해 일관성을 유지하도록 도와줍니다.

고급 캐시 관리 기법

고급 캐시 관리 기법에는 예측 기반 캐시 관리, 동적 캐시 크기 조정, 그리고 다양한 최적화 알고리즘들이 포함됩니다. 예측 기반 관리 기법은 데이터의 접근 패턴을 분석하여, 자주 사용될 데이터를 미리 캐시하는 방법입니다. 이 방식은 시스템 성능을 크게 향상시킬 수 있습니다.

결론

캐시 메모리는 CPU 성능을 극대화하는 중요한 요소입니다. 다양한 캐시 계층과 알고리즘을 적절하게 활용함으로써, 시스템의 성능을 최적화할 수 있습니다. 특히 멀티코어 시스템에서는 캐시 일관성 및 효율적인 캐시 관리가 핵심적인 역할을 하며, 최신 기술들을 통해 캐시의 성능은 계속해서 향상되고 있습니다.

Q&A

Q: 캐시 메모리의 계층이 많을수록 좋은가요?

A: 계층이 많다고 항상 좋은 것은 아닙니다. 각 계층은 성능과 비용 사이의 균형을 맞추기 위해 설계됩니다. 너무 많은 계층이 추가되면 관리가 복잡해지고, 비용이 증가할 수 있기 때문에 시스템 설계에서 적절한 균형이 필요합니다.

Q: 캐싱 알고리즘을 선택하는 기준은 무엇인가요?

A: 캐싱 알고리즘의 선택은 시스템의 데이터 접근 패턴에 따라 달라집니다. 예를 들어, 데이터가 주로 최근에 접근된 경우 LRU가 유효하며, 빈번한 데이터 사용이 예상되는 시스템에서는 LFU가 더 적합할 수 있습니다.

마무리하며

캐시 메모리 계층 구조와 캐싱 알고리즘은 컴퓨터 시스템의 성능을 결정짓는 중요한 요소입니다. 이를 잘 이해하고 활용하는 것이 시스템 성능 최적화의 핵심입니다. 최신 기술이 지속적으로 발전하는 가운데, 효율적인 캐시 관리 전략을 채택하는 것이 필수적입니다. 이러한 기술들은 향후 더 많은 멀티코어 프로세서와 고급 시스템에서 중요한 역할을 하게 될 것입니다.

캐시 메모리, 캐싱 알고리즘, LRU, FIFO, LFU, CPU 성능 최적화, 멀티코어 시스템, 캐시 일관성, 시스템 성능, 캐시 관리